Archivo Robots.txt: Qué es y cómo crearlo

Cuando lanzas una página web o una tienda online necesitas que Google rastree la información, pero también tienes que darle una serie de directrices o instrucciones acerca de cómo debe interactuar con tu contenido. Por tanto, necesitas crear un archivo robots.txt.

Pero, ¿sabes qué es el archivo robots.txt y para qué sirve? ¿Necesitas ayuda para crear uno?

Si es así, sigue leyendo porque en este artículo te explico todo lo que necesitas sabes sobre el archivo robots.txt y cómo crear y subir el tuyo a Google.

¡Empecemos!

Tabla de contenidos:

- ¿Qué es el archivo robots.txt?

- ¿Por qué es importante el archivo robots.txt?

- ¿Cómo funciona un archivo robots.txt?

- ¿Dónde está el archivo robots.txt?

- Reglas y formato del archivo robots.txt

- Principales comandos de robots.txt

- Cómo crear un archivo robots.txt

- Crear el archivo robots.txt en WordPress

- Enviar el archivo robots.txt a Google

- ¿Te ha resultado complicado crear un archivo robots.txt para tu web?

¿Qué es el archivo robots.txt?

El archivo robots.txt es un archivo de texto, de ahí la extensión .txt, que sugiere a los buscadores, como Google, qué URLs de nuestro sitio deben rastrear y a qué partes de la página web no quieres que accedan los bots para rastrear el contenido.

Por decirlo de otra manera, el archivo robots.txt contiene un listado de URLs que no deseas que los buscadores como Google rastreen ni se muestren en los resultados de búsqueda.

Como sabrás, por defecto, los robots o arañas de Google rastrean todo el contenido de tu página web (y cuando digo todo, es TODO). Pero, ¿qué ocurre si tienes un directorio que no deseas que Google lo indexe? Lo ideal es incluirlo en este archivo. De esta manera, cuando un robot visite tu sitio, antes comprobará el archivo robots.txt y sabrá qué instrucciones seguir.

No confundas noindex con robots.txt

¡Ojo! Incluir una determinada URL en el archivo robots.txt no garantiza que Google no la vaya a indexar. Al hacerlo, solo le estás sugiriendo a Google que no lo haga, pero al final, él decidirá…. 😛

Si realmente no quieres que una página web aparezca en Google, lo ideal es utilizar la etiqueta noindex o proteger la página con una contraseña.

¿Por qué es importante el archivo robots.txt?

Si aún no tienes claro por qué es imprescindible añadir un archivo robots.txt a tu web, aquí te muestro algunas razones. ¡Así que toma nota!

- Control del rastreo: Permite a los administradores de sitios web gestionar qué partes del sitio pueden ser examinadas por los motores de búsqueda. Esto es crucial para evitar que se indexen páginas irrelevantes o sensibles y asegura que el rastreo se concentre en las secciones más importantes para el SEO.

- Optimización del rendimiento del sitio: Al restringir el rastreo de ciertas secciones del sitio, como scripts, hojas de estilo o páginas duplicadas, puedes reducir la carga en tu servidor. Esto es especialmente relevante para sitios grandes o con muchos recursos, ya que los rastreadores pueden consumir ancho de banda y recursos del servidor.

- Seguridad del contenido sensible: El archivo robots.txt puede bloquear el acceso de los motores de búsqueda a directorios o archivos que contienen información privada o confidencial, como páginas de inicio de sesión, datos de usuario o contenido delicado. Aunque no garantiza una protección total, es un primer paso para evitar que esta información sea expuesta públicamente.

- Mejora del SEO: Al guiar a los rastreadores hacia las páginas clave y evitar que indexen contenido irrelevante o duplicado, el archivo robots.txt contribuye a una estrategia de SEO más efectiva. Esto facilita que los motores de búsqueda se enfoquen en las páginas más importantes para atraer tráfico orgánico.

- Control de errores y redirecciones: El archivo robots.txt puede ayudarte a gestionar el rastreo de páginas eliminadas o redirigidas, evitando que los motores de búsqueda muestren contenido desactualizado en sus resultados.

Apuesto a que ahora tienes mucho más claro por qué es importante contar con un archivo robots.txt en tu web, ¿verdad? 😉

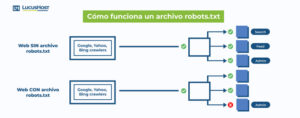

¿Cómo funciona un archivo robots.txt?

La función principal del archivo robots.txt es ofrecer instrucciones a los motores de búsqueda (también conocidos como «bots» o «crawlers») sobre qué partes del sitio web pueden o no pueden rastrear e indexar. A continuación, te explico cómo funciona:

Ubicación del archivo

El archivo robots.txt se sitúa en la raíz del dominio. Cuando un bot de motor de búsqueda accede a tu sitio, su primer paso es buscar este archivo para identificar si hay restricciones en el rastreo.

Estructura del archivo

El archivo robots.txt sigue una estructura específica para definir las reglas de rastreo. Primero, el comando User-agent indica a qué bots se aplican las siguientes reglas. Los bots, como Googlebot para Google, se identifican por nombres específicos, aunque también se puede usar el asterisco (*) como comodín para aplicar las directrices a todos los bots.

A continuación, el comando Disallow especifica las URL o directorios que no deseas que los bots rastreen. Si quieres bloquear una URL en particular, simplemente la colocas después de Disallow.

El comando Allow permite el rastreo de subrutas específicas dentro de un directorio bloqueado. Si dentro de un directorio prohibido quieres permitir el acceso a una página concreta, lo puedes hacer con Allow.

Finalmente, aunque no es obligatorio, puedes añadir una línea con Sitemap para incluir la URL de tu archivo sitemap.xml. Esto ayuda a los bots a encontrar y rastrear todas las páginas de tu sitio que deseas que se indexen.

Si te parece complicado, no te preocupes. Te mostraré un ejemplo sencillo para que lo entiendas mejor:

User-agent: * Disallow: /admin/ Allow: /admin/help.html Sitemap: www.tuweb.com/sitemap.xml

Como puedes ver, todos los bots (**User-agent: * **) tienen prohibido rastrear el directorio /admin/, pero se les permite acceder a la página específica /admin/help.html. Además, se proporciona la ubicación del archivo del mapa del sitio para facilitar la indexación de las páginas del sitio web.

Comportamiento de los bots

Los bots de motores de búsqueda leen el archivo robots.txt para decidir qué contenido deben explorar o evitar. Las páginas y archivos que se permiten en robots.txt serán rastreados e indexados, lo que significa que podrán aparecer en los resultados de búsqueda.

Aunque la mayoría de los bots siguen las instrucciones del robots.txt, algunos bots maliciosos pueden no cumplirlas.

Limitaciones

Bloquear una página en robots.txt no la protege de ser accesible, solo indica a los motores de búsqueda que no la rastreen. Si una URL bloqueada es enlazada desde otro sitio, puede ser indexada sin rastreo.

Como mencioné anteriormente y quiero reiterar (más que nada, ya que es muy importante 😊), si otros sitios enlazan a una página bloqueada y los bots la descubren, esta puede ser indexada a pesar de que el archivo robots.txt lo prohíba. Para prevenir la indexación, es necesario utilizar métodos adicionales, como la etiqueta noindex en el HTML de la página.

¿Dónde está el archivo robots.txt?

Anteriormente, cuando te expliqué el funcionamiento del archivo robots.txt, ya te adelanté que este archivo se encuentra en la raíz de tu página web. De hecho, tiene una ruta del tipo:

- https://tudominio.com/robots.txt

Reglas y formato del archivo robots.txt

Antes de ver los principales comandos que puedes incluir en el archivo robots.txt, es importante que tengas en cuenta algunos aspectos.

- El archivo debe llamarse sí o sí robots.txt. No puede tener otro nombre, de lo contrario no será leído por los robots.

- Tu web únicamente puede tener un archivo robots.txt.

- El archivo robots.txt debe ubicarse en la raíz de la web, no en un subdirectorio. Por tanto, https://tudominio.com/robots.txt sería válido, pero https://tudominio.com/blog/robots.txt no lo sería.

- Puedes crear un archivo robots.txt para un subdominio que aplique únicamente a ese subdominio. Por ejemplo, https://shop.tudominio.com/robots.txt sería válido para el subdominio shop.tudominio.com.

Principales comandos de robots.txt

Para crear el archivo robots.txt, es importante que conozcas algunos comandos básicos.

Comando User-agent

Este comando indica qué robot tiene que cumplir las directivas que componen en el archivo.

Si no quieres especificar qué robot debe cumplir las indicaciones, utiliza el siguiente comando:

User-agent: *

Para dar instrucciones específicas al robot de Google debes establecer:

User-agent: googlebot

En el caso del robot de Bing debes utilizar:

User-agent: googlebot

Comando Disallow

Este comando indica qué directorio o página de tu web no debe incluirse en los resultados de búsqueda.

En WordPress, es muy común bloquear todas las URLs del panel de administración. Para ello se utiliza:

Disallow: /wp-admin

O, en el caso del área de clientes, podrías utilizar:

Disallow: /area-de-clientes

Para indexar todo el contenido:

Disallow:

O, por el contrario, si no quieres que se rastree ninguna página del sitio:

Disallow: /

Comando Allow

Con este comando, indicas a los motores de búsqueda qué páginas o directorios deseas que sean rastreados.

Por defecto, se rastrea todo el contenido, por lo que solo necesitas este comando si quieres permitir el acceso a un contenido que has bloqueado con el comando Disallow. Por ejemplo:

Disallow: /noticias Allow: /noticias/actualidad

Comando Sitemap

El archivo robots.txt ayuda a los motores de búsqueda a indexar el contenido, por lo que también es muy útil incluir en él el sitemap de tu sitio web.

Aunque es opcional, puedes añadir este comando incluyendo la ruta del mapa o mapas de tu sitio:

Sitemap: https://tudominio.com/sitemap.xml

¿Todavía no tienes creado el sitemap en tu sitio? Entonces, te recomiendo que le eches un ojo a estos artículos:

Comando Crawl-delay

Este comando sirve para retrasar el tiempo de rastreo entre página y página para no afectar al rendimiento de tu sitio. Es especialmente útil para sitios web muy grandes.

Crawl-delay: 1

Comodines $, * y #

Además de los comandos, existe una serie de comodines que resultan útiles y necesarios para crear un archivo robots.txt:

- $: el símbolo del dólar indica el final de una URL.

- *: el asterisco representa «todos».

- #: la almohadilla sirve para incluir comentarios en el archivo.

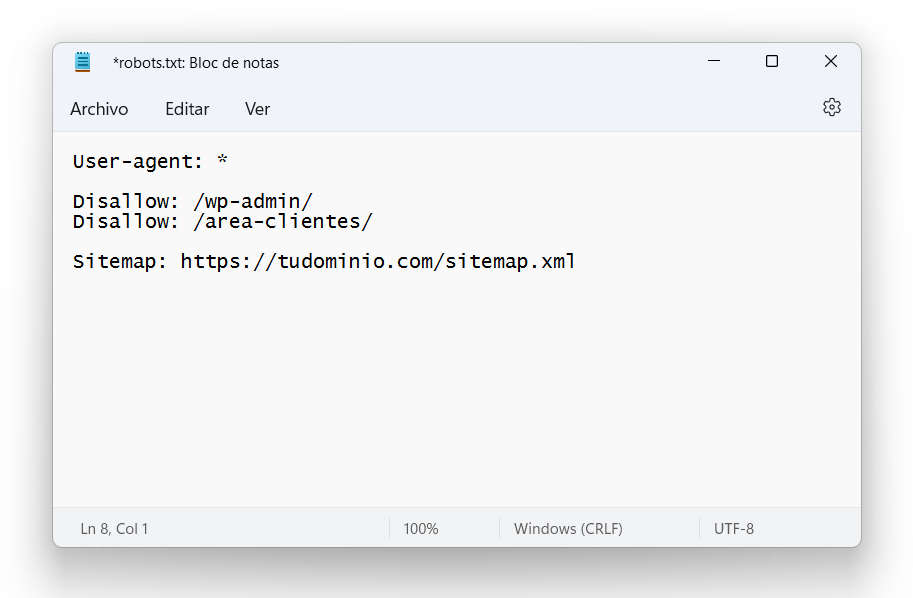

Cómo crear un archivo robots.txt

Cuando instalas algunas aplicaciones como PrestaShop o Mautic, verás que ya tienen el archivo robots.txt preconfigurado en la raíz del dominio. Sin embargo, en otros gestores de contenido como WordPress, es necesario crear y subir el archivo robots.txt al hosting.

¿Quieres ver cómo crear un archivo robots.txt? Vamos a ello.

- Abre un editor de texto como, por ejemplo, el bloc de notas de Windows.

- Establece el user-agent. Puedes utilizar el comodín * para referirte a cualquier robot, o «googlebot» si las directrices son únicamente para el robot de Google.

- Escribe las reglas que debe interpretar el user-agent. Utilizando los comandos que te mostré anteriormente, establece qué URL prefieres que Google no rastree.

- Añade la ruta del sitemap de tu sitio.

- Guarda el archivo con el nombre robots.txt y súbelo a la raíz de tu sitio. Esto puedes hacerlo mediante una conexión FTP o utilizando el Administrador de archivos de cPanel.

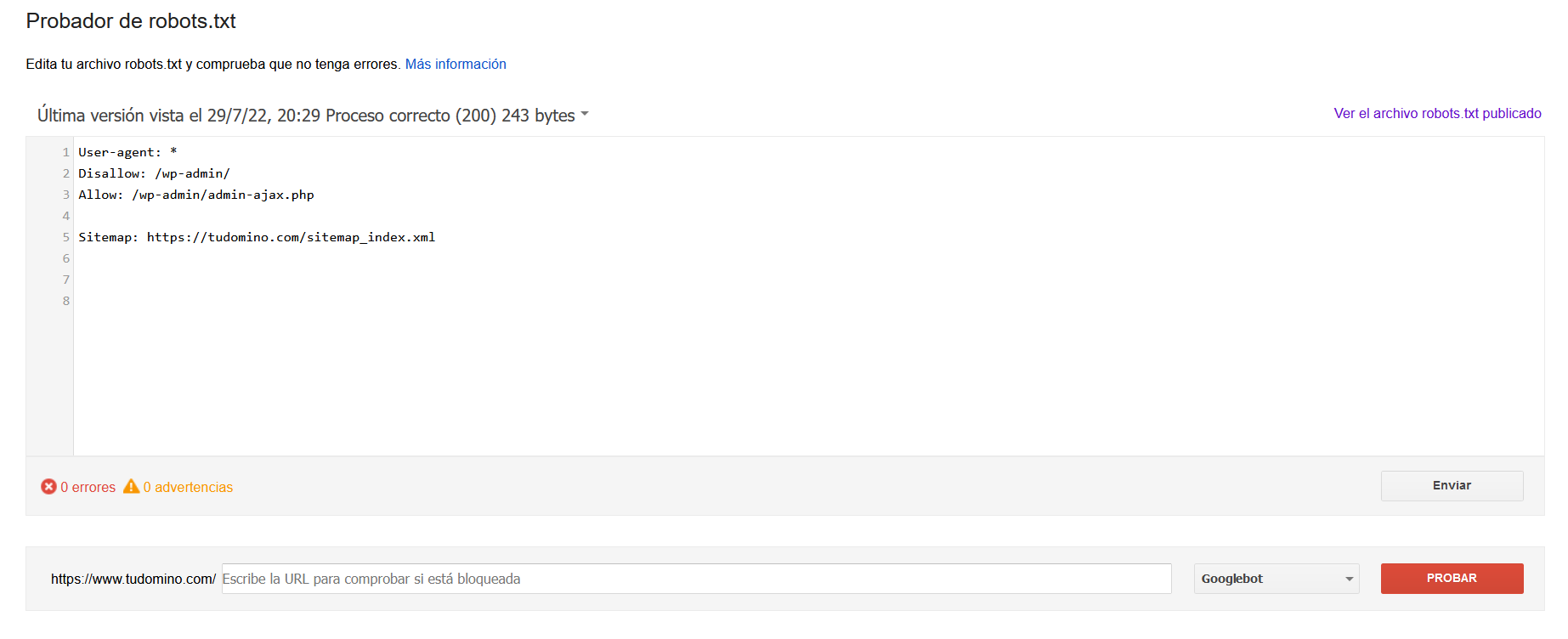

- Comprueba si es archivo robots.txt es legible o presenta algún error desde la herramienta Robots Testing Tools de Google Search Console

Aquí tienes un ejemplo de un archivo robots.txt sencillo:

Crear el archivo robots.txt en WordPress

Teniendo en cuenta que WordPress es el gestor de contenidos más utilizado para crear páginas web, es importante aclarar que, aunque este gestor de contenidos no genera el archivo robots.txt por defecto durante la instalación, muchos plugins, como Rank Math o Yoast SEO, lo hacen automáticamente por ti.

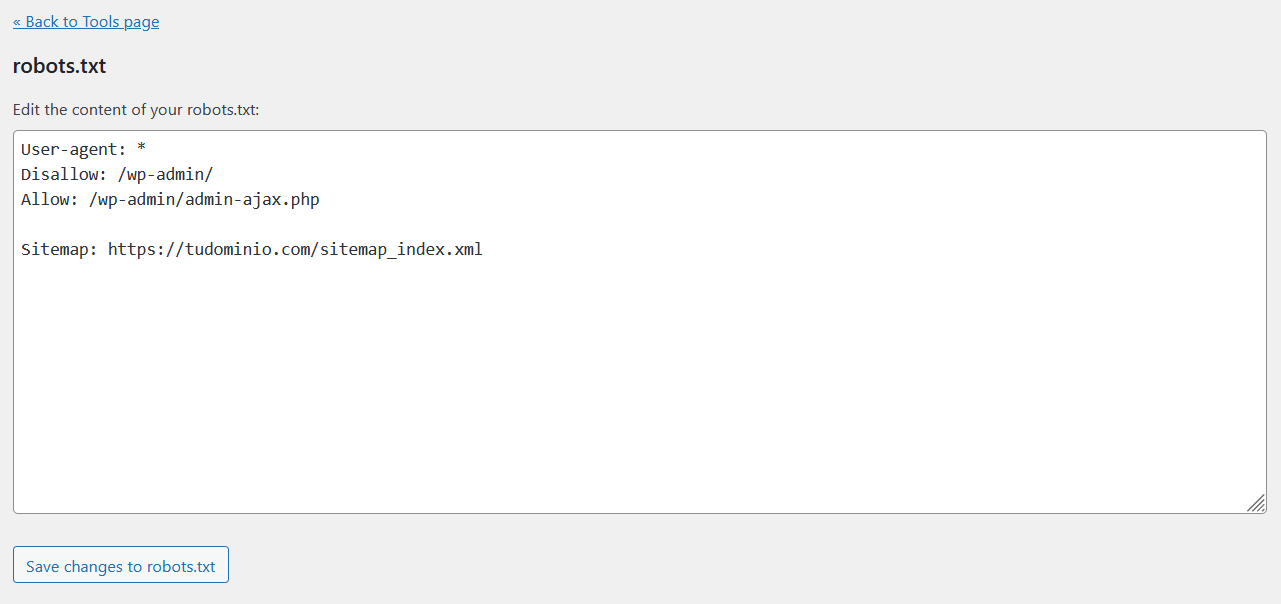

Crear el archivo robots.txt con Yoast SEO

Si tienes instalado Yoast SEO en tu aplicación, puedes crear y modificar este archivo en solo un par de clics. De hecho, es así de sencillo:

- Accede al panel de administración de WordPress y, en el menú lateral, haz clic en «Yoast SEO» para abrir la configuración del plugin.

- Abre la sección «Tools» o «Herramientas» y selecciona la segunda opción «File editor».

- Desde aquí verás que Yoast SEO te da la opción de crear el archivo robots.txt pulsando en el botón «Create robots.txt file».

- Por defecto, se genera un archivo robots.txt como este, pero puedes añadir nuevas directrices o eliminar las que no se ajusten a tu sitio.

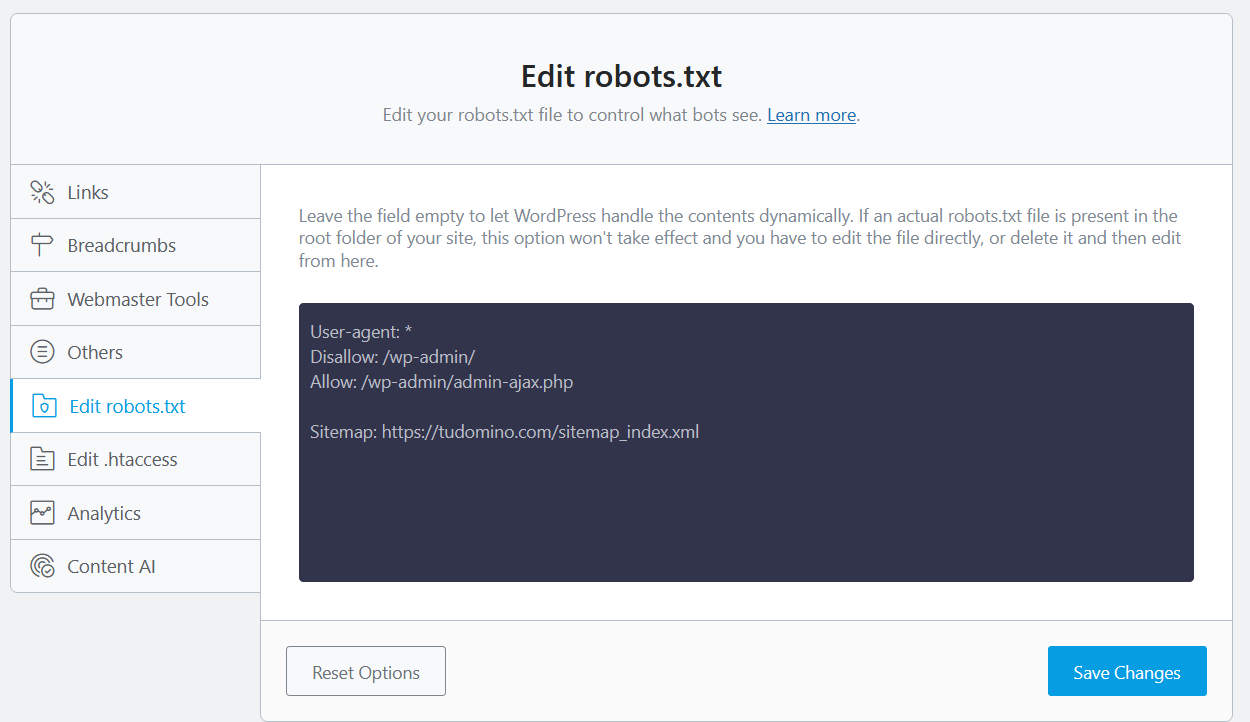

Crear el archivo robots.txt con Rank Math

Si utilizas este plugin para mejorar el posicionamiento de tu sitio, el proceso es igual de sencillo que con el plugin que acabamos de ver.

- Accede al panel de administración de tu web y, en el menú de WordPress, pulsa en Rank Math.

- Ve a «General Settings» (ajustes generales) y, a continuación, haz clic en «Edit robots.txt».

- Se abrirá una pestaña como esta en la que debes incluir las directrices que quieres que sigan los motores de búsqueda.

📢 Importante: Aunque utilices alguno de estos plugins para crear el archivo robots.txt, no olvides enviarlo a Google a través de Search Console.

Enviar el archivo robots.txt a Google

Una vez que hayas creado el archivo robots.txt, te preguntarás: ¿cómo hago para enviarlo a Google?

En la página de Google Developers, se indica lo siguiente:

Una vez que hayas subido y probado tu archivo robots.txt, los rastreadores de Google buscarán y empezarán a usar el archivo robots.txt automáticamente. No tienes que hacer nada.

Actualizar el archivo robots.txt en Google

Si ya has creado el archivo y solo has actualizado las directrices añadiendo o eliminando alguna, entonces deberás reemplazar el archivo existente con la nueva versión.

En este caso, desde Google Developers nos indican que los rastreadores detectan los cambios hechos en el archivo robots.txt y actualizan la versión almacenada cada 24 horas.

Pero… ¿No puedes esperar tantas horas? ¿Necesitas que se actualice con mayor rapidez? Entonces haz lo siguiente:

- Abre el Probador de robots.txt de Search Console y haz clic en «Ver la versión subida» para comprobar qué archivo robots.txt se está utilizando.

- Haz clic en «Enviar» para avisar a Google de que tu archivo se ha actualizado.

Si quieres, puedes comprobar que esta actualización se realizó correctamente volviendo a la herramienta de Probador de robots.txt del punto 1.

¿Te ha resultado complicado crear un archivo robots.txt para tu web?

Un archivo robots.txt permite a los buscadores, como Google, saber qué URLs de una página web deben rastrear y a qué partes no deben acceder los bots.

Este archivo, que debe tener la extensión .txt y estar ubicado en la raíz del sitio, indica a qué partes de la web no quieres que accedan los rastreadores de los motores de búsqueda.

Como hemos visto, puedes crear este archivo usando el Bloc de notas. No obstante, si utilizas WordPress, la mayoría de los plugins de SEO te permiten hacerlo con solo un par de clics.

Ahora dime, ¿ya has creado tu archivo robots.txt? ¿Tienes alguna duda? Déjame un comentario y te echo una mano 🙂

No hay comentarios